网站获得搜索引擎抓取值得期待的。

![图片[1]-如何禁止搜索引擎抓取网站-友沃可](https://i.uvooc.com/wp-content/uploads/2020/06/timg.jpg)

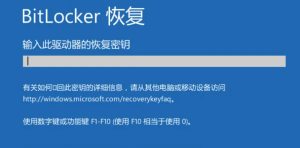

然而,某些特殊的情况是我们不愿意让网站抓取全部或部分内容。

最好的办法就是借助robots.txt文件。

Robots.txt在书写的时候有特定的命令和语法。

三个命令,两个通配符

User-agent:

用于描述搜索引擎蜘蛛的名字。在robots里面至少要有一条User-agent:记录。此值可以使用符号,其代表的意思是对所有搜索引擎蜘蛛都有效。例如:User-agent:就是所有的搜索引擎蜘蛛都会受到后面Disallow和allow的限制。

如果只是为了限制某一个搜索引擎蜘蛛的抓取可以使用User-agent:蜘蛛名称

例如:User-agent:sosospider 就是限制搜搜搜索引擎的蜘蛛来抓取。

Disallow:

禁止,不希望被搜索引擎抓取

使用disallow命令可以禁止不希望蜘蛛进行抓取的url

如果使用了这条规则Disallow:/news那么作用就是不允许抓取/news.html和/newsabc.htm只要路径中出现news都不会被抓取。

Allow:

允许,可以抓取

使用allow命令可以允许蜘蛛来抓取某个路径或者目录

如:Allow:/seonews可以抓取/seonews.html使用Allow命令一般是配合Disallow一起使用的。当要限制抓取某个目录但又想让抓取目录里面的指定路径时就可以使用相应的命令。

这里要说下,不写robots或者robots是空的时候,默认情况下都是允许抓取的;

建议如果你是一个新手且对robots不了解的话不要盲目去添加robots链接,不然会对网站收录错误的屏蔽造成不良的影响。

经常有遇到这种情况错误屏蔽的案例,导致网站不能被收录出现流量异常。

下面是两个通配符

*(匹配0或者多个任意字符)

$(匹配行结束符)

例如

禁止所有的搜索引擎访问网站全部内容

User-agent:*

Disallow:/

禁止百度搜索引擎访问网站全部内容

User-agent:Baiduspider

Disallow:/

允许所有搜索引擎访问全部内容;也可以为空

User-agent:*

Allow:/

允许/禁止百度搜索引擎抓指定格式的图片

User-agent:Baiduspider

Allow:/.gif$ Disallow:/.jpg$

允许/禁止百度搜索引擎抓取网站的动态页面

User-agent:Baiduspider

Allow:/.php$ Disallow:/.jsp$

1 本网站名称:友沃可-简记与叙。

2 本站网址:https://i.uvooc.com

3 本网站的文章部分内容可能来源于网络,仅供大家学习与参考。

4 如有侵权,请联系站长i@uvooc.com 进行删除处理。

暂无评论内容